Projekt-Einblicke: Wie rendersnek eine dokumentarische Werbung mit KI produzierte

Entdecke, wie rendersnek ein komplettes FOOH-Konzept mit KI erstellt hat – von Umgebungen und Charakteren bis hin zur Erzählung – und was Studios daraus lernen können.

Ein Gastartikel von rendersnek

Jedes FOOH- oder CGI-Studio ist schon mindestens einmal auf dieses Problem gestoßen: Ein Kunde kommt mit einer Idee herein, die so groß und technisch anspruchsvoll ist, dass sie fast an eine Hollywood-Produktion grenzt.

Letztes Jahr kam Kockum Sonics – ein Schweizer Unternehmen, das sich auf akustische Alarmsysteme spezialisiert hat – mit einer Idee, die damals für eine klassische Produktion zu ehrgeizig erschien.

Dieses Jahr hatte sich die Situation geändert. Mit einer Welle neuer KI-Tools auf dem Markt wurden Aufnahmen, die sich einst „unmöglich" angefühlt hatten, plötzlich mit einem Bruchteil des Budgets machbar. Also griffen wir das Konzept wieder auf – nicht nur, um den Auftrag zu erfüllen, sondern um es als Testfeld für die heutige hochmoderne KI-Pipeline zu nutzen.

Wir verwandelten ihre Vision in ein vollständiges Experiment: Könnten wir eine komplette Mini-Dokumentation mit KI erstellen, von Umgebungen und Charakteren bis hin zu Erzählung und Katastrophenszenen? Und ganz am Ende überraschten wir den Kunden mit dem Ergebnis.

Wir wussten von Anfang an, dass dies keine Aufgabe für eine klassische FOOH-Produktion war, für die wir normalerweise engagiert werden. Dennoch wollten wir es angehen. Also wurde es zu einem offenen Experiment: Könnte ein komplettes visuelles Konzept ausschließlich mit KI produziert werden?

Was als Fragezeichen begann, wurde zu einem vollständig realisierten 30-Sekunden-KI-Film – komplett mit Umgebungen, Charakteren, Katastrophenszenen und einem authentischen Erzähler, der die Geschichte trägt. Und so haben wir es gemacht.

Phase 1: Recherche & Referenzbeschaffung (Grundlagen für die Bilderstellung)

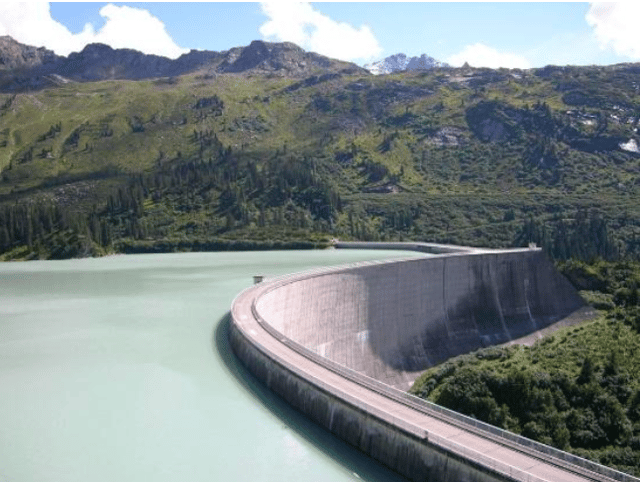

Zuerst begannen wir mit der Referenzsuche: Stauseen, Staumauerarchitektur, Alpentäler. Die Kaprun-Staumauer in Österreich diente als besonders starker Anker für Maßstab und Struktur.

Von dort aus trat ChatGPT als unser Bild-Co-Regisseur auf. Wir warfen nicht sofort komplette Szenenbeschreibungen darauf. Stattdessen arbeiteten wir in engen Iterationen: ein visueller Hinweis nach dem anderen, oft pausierend, um zu verfeinern, bevor wir das nächste Detail hinzufügten – sei es Optik, Standort oder Atmosphäre.

Anstatt alles Bild für Bild zu skripten, half uns ChatGPT dabei, diese Referenzen direkt in Bildprompts zu übersetzen. Dieser Prozess wurde zum Motor für die Generierung der ersten verwendbaren Grundbilder.

Phase 2: Grundbilderstellung – Charaktere und Umgebungen

Zwei Säulen trieben diese Phase an:

Ein dokumentarischer Erzähler (ruhig, intelligent, draußen) und

Die Umgebungsgrundbilder (Staumauer, Stausee, Tal, Waldlinien, Perspektiven unterhalb der Staumauer).

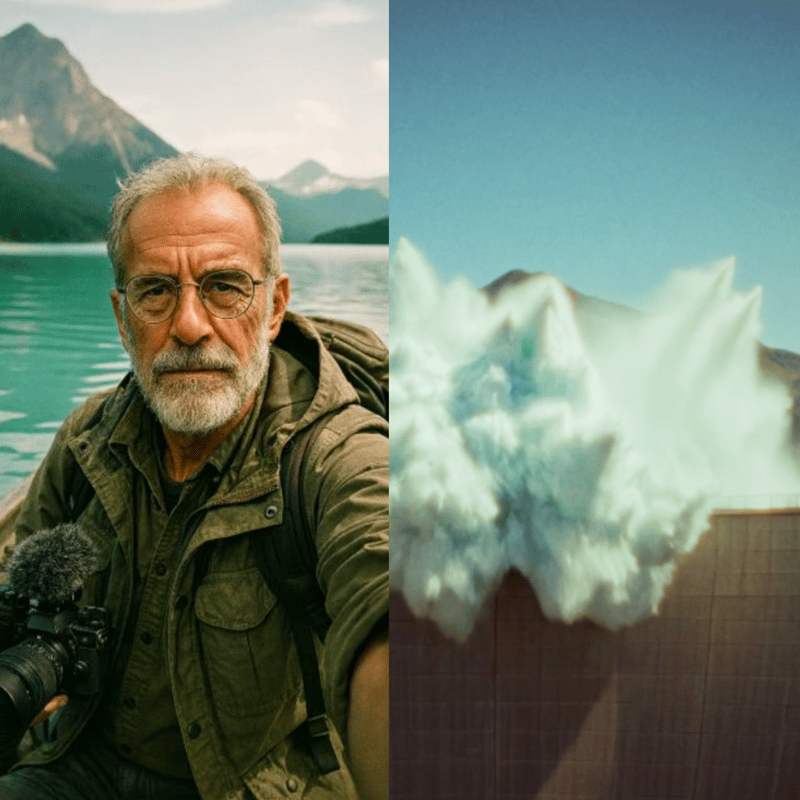

Für den Charakter bestand die Herausforderung darin, jemanden zu entwerfen, der authentisch wirkte, eine Figur, die überzeugend eine dokumentarische Stimme über mehrere Szenen hinweg tragen konnte, während sie visuell konsistent blieb. Wir begannen mit realen Referenzen: ältere Männer mit Brille, hellem Bart und Outdoor-Kleidung.

Von dort aus bauten wir die Persona durch einen iterativen Prompt-Dialog mit ChatGPT auf. Indem wir in kleinen Schritten vorwärts gingen – pausierend für „warte auf weitere Anweisungen", dann neue Hinweise wie Standort oder Kameraoptik schichteten – formten wir einen photorealistischen Erzähler, der nie wirklich existierte, aber sofort Glaubwürdigkeit und Vertrautheit ausstrahlte.

Verwendete Prompt-Fragmente (Beispiele):

„Klassischer Dokumentarsprecher, älterer Mann 60–70, dünne Brille, heller Bart, Forscher-Outfit."

„Hyper-photorealistisch, analoger Film-Look – Kodak Portra 400, Zeiss 50 mm, Minolta XD1, leichte Körnung, 3:4 Porträt."

„Er filmt sich selbst in Selfie-Perspektive auf einem Ruderboot im Stausee, schaut in die Kamera; platziere etwas Outdoor-/Kameraausrüstung im Boot."

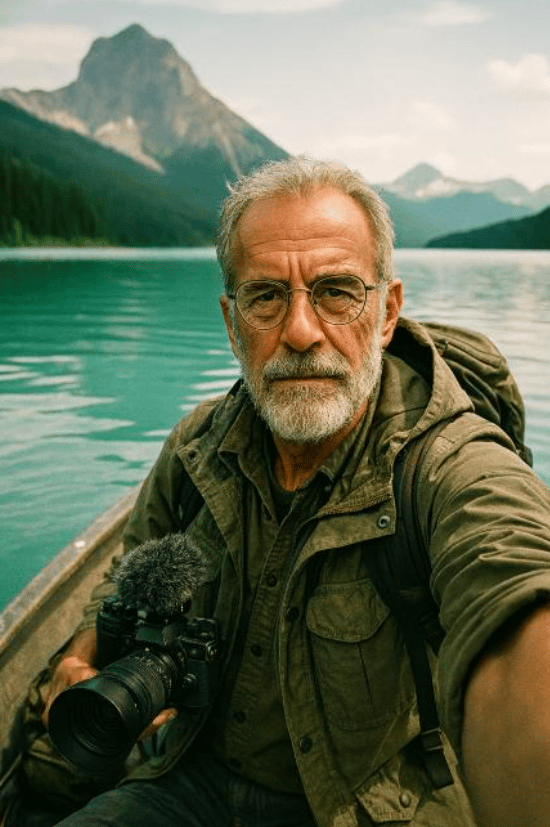

Die Umgebungen erforderten eine andere Art von Disziplin: Sie mussten geografisch stabil bleiben, damit spätere Videosequenzen kohärent wirken würden. Die Kaprun-Staumauer in Österreich wurde zu einem wichtigen Anker für Maßstab und Struktur. Mit dieser und anderen Referenzen generierte ChatGPT eine erste Bibliothek von Grundbildern – von der Staumauer und dem Stausee bis hin zu Talperspektiven darunter. Photoshops Generative KI verfeinerte und erweiterte dann diese Ausgaben: korrigierte Fehler, erweiterte Rahmen in kinematografische Formate und fügte kleine, identitätsstiftende Details wie Hütten oder Baumlinien ein, um sicherzustellen, dass jede Einstellung authentisch und verbunden aussah.

Phase 3: Konsistenz mit dem Flux-Kontextmodell

Um den Look des Erzählers über verschiedene Einstellungen hinweg zu erweitern und zu stabilisieren, verwendeten wir das Flux-Kontextmodell, um zusätzliche Vlog-Style-Standbilder zu generieren, die auf dem Grundporträt basieren. Wenn Ausgaben abdrifteten (Merkmale, Kleidung, Mikro-Stil), fixierten wir sie entweder in Photoshop oder durch erneutes Ausführen ausgewählter Flux-Durchläufe, bis das Charakter-Kit felsensolide war.

Phase 4: Sprechende Vlogs mit Higgsfield (Google Veo 3, „Speak")

Mit fertigen Charakter-Standbildern wechselten wir zu Higgsfield, das Google Veo 3 und ein eingebautes „Speak"-Tool für sprechende Charaktere nutzt (Lippensynchronisation, Gesichtsmikrobewegungen und Audio).

Was bei Higgsfield in der Praxis gut funktionierte:

- Konsistenz der Stimmidentität auch über verschiedene Grundbilder desselben Charakters hinweg.

- Enge Kopplung von Audio und generierter Bewegung innerhalb eines Workflows (weniger Übergaben).

- Schnelle Iteration für Talking-Head-Inhalte – ideal für die Vlog-Segmente, die den Zuschauer „an die Hand nehmen" durch die Geschichte.

Verwendeter Beispiel-Prompt: „Dieser Dokumentar-Vlogger steht vor einer Staumauer inmitten ruhiger Natur und spricht mit ruhiger und neugieriger Stimme zu seinen Zuschauern. Er klingt wie ein alter Dokumentarsprecher."

Über verschiedene Takes und Einstellungen hinweg behielt der Charakter dieselbe stimmliche Persönlichkeit und visuelle Kohärenz.

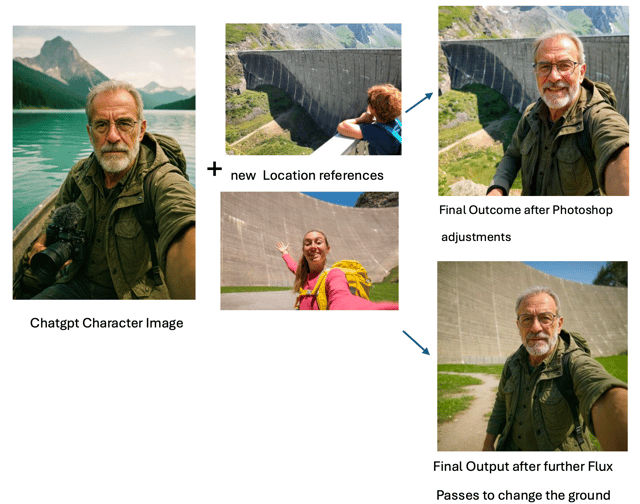

Phase 5: Katastrophen-Kinematografie mit Kling 2.1 Master

Für kinematografische Action und Natur testeten wir Veo 2, Veo 3 und andere. Innerhalb der KI-Suite von Freepik war der klare Gewinner für die komplexen Katastrophensequenzen Kling 2.1 Master. Es war das einzige Modell, das mit genügend Iteration glaubwürdig rendern konnte:

- einen Erdrutsch, der in einen Bergsee stürzt (0:16),

- die daraus resultierende Flutwelle, die das Tal bedroht (0:23), und

- die Sirene, die schockwellenartige Impulse aussendet, die die Welle treffen und „neutralisieren" (die buchstäbliche Auflösung des Films) (0:30).

Diese Prompts waren hochspezifisch und nicht-generisch; die meisten Modelle hatten Schwierigkeiten, sie zu parsen.

Kling war nicht magisch aus der Box heraus, aber es gab uns verwendbare Bausteine nach beharrlichem Experimentieren.

Um den Prompting-Prozess zu unterstützen, verwendeten wir den Freepik Prompt Enhancer, der half, visuelle Anweisungen präziser zu artikulieren – besonders wenn die richtige Sprache für einen Nischeneffekt schwer zu finden war.

Für einfachere Sequenzen funktionierte Kling tadellos mit minimalem Aufwand – wo Beobachtungen wie „realistische Bewegung, sanfte Kameraübergänge, hohe Prompt-Adhärenz, kosteneffektiv" ursprünglich herkamen:

- Etablierungsaufnahmen der Staumauer,

- weite Luftperspektiven,

- sanfte Schwenks und Kameraverhalten,

- überzeugende natürliche Beleuchtung.

Das waren die Stellen, wo es einfach funktionierte – schnell und sauber.

Prompt zur Erzeugung der Luftaufnahme:

„Kamera steigt langsam auf, neigt sich nach unten, während die Sicht zu einer Vogelperspektive über den ruhigen See übergeht. Die Szene zeigt die Staumauer und umliegenden Berge in lebendigen Details und hebt die natürliche Schönheit der Landschaft hervor."

Phase 6: Stimmklonen mit ElevenLabs

Wir wollten dieselbe Stimme aus den Higgsfield-Vlogs für ein längeres, szenenübergreifendes Voice-Over. Wir begannen mit dem Training eines Stimmklons auf ElevenLabs unter Verwendung der wenigen verfügbaren Higgsfield-Clips (keineswegs optimal). Idealerweise würdest du über die gesamte Bandbreite einer Stimme trainieren – verschiedene Emotionen, Tempo, Intensität, Umgebungen und so weiter.

Trotzdem war der Klon überraschend gut angesichts der begrenzten Trainingsdaten: ziemlich konsistentes Timbre, meistens erkennbar derselbe Erzähler und gut genug, um das Voice-Over des Films mit ein paar kleineren manuellen Anpassungen hier und da zu tragen. Mit einem breiteren Datensatz würden wir weit größere Nuancen, Dynamikbereich und Realismus erwarten.

Phase 7: Den Klon arbeiten lassen und erzählerische Emotion herausfinden

Es war nun Zeit, tatsächlich das Voice-Over für den Film mit dem neu erstellten Stimmklon zu produzieren. ChatGPT kam schnell mit einem Text für den Sprecher auf, der nach einigen menschlichen Anpassungen durch unser Kreativteam bereit für das Voice-Over war.

Da frühe Generationen ziemlich neutral wirkten, tauchten wir in ElevenLabs-Optionen und Skript-Taktiken ein und erforschten, was getan werden könnte. ElevenLabs empfiehlt offiziell, eine Art erzählerische Anweisung nach der gesprochenen Zeile im Skript zu platzieren:

z.B., „Stationäre Sirenen", sagte er langsam und ernst.

Durch Testen entdeckten wir jedoch, dass das Gegenteil besser funktionierte: die emotionale Anweisung vor der gesprochenen Zeile zu platzieren. Zum Beispiel:

Langsam und mit Gewicht erklärt er: „Stationäre Sirenen."

Diese Methode stellte sicher, dass die KI-Stimme bereits „im Charakter" war, wenn die Zeile gesprochen wurde. Der allgemeine Nachteil von erzählerischen Hinweisen: Diese führenden Hinweise müssen danach manuell herausgeschnitten werden. Der Vorteil: Die Darstellung ist viel, viel überzeugender.

Andere wichtige Techniken umfassten:

- Verwendung von <break time=“1.0s” /> Markierungen für präzise Pausen anstatt sich auf Interpunktion zu verlassen.

- Anpassung der Stabilitätseinstellung, um zwischen ausdrucksstarker Variation und konsistentem Ton zu balancieren

Die Kombination dieser Ansätze verwandelte das Voice-Over von robotisch zu narrativ fesselnd.

Phase 8: Finale Montage & Ton

Der finale Durchgang brachte zusammen:

- Vlog-Clips (Higgsfield / Veo 3 Speak),

- Katastrophen- und Landschaftssequenzen (Freepik Kling 2.1 Master),

- Grundbilder & Umgebungsvisuals, die hauptsächlich mit ChatGPT generiert wurden (dann verfeinert über Photoshops Generative KI und, für Kontinuität, das Flux-Kontextmodell)

- Voice-Over (ElevenLabs-Klon mit geskripteter Erzählung),

- Sound-Design, Schnitt und Timing (Manuelle Politur mit DaVinci Resolve, beinhaltet auch ein automatisches Untertitel-Tool, das wir als Basis für das Timing verwendeten).

Das fertige Stück ist ein kohärenter, vollständig KI-generierter Kurzfilm – menschlich geleitet, maschinenausgeführt und manuell geschnitten und finalisiert.

Reflexionen & Erkenntnisse

Rückblickend zeigte uns dieses Projekt sowohl die Stärken als auch die Grenzen der heutigen KI-Pipeline. Es ist erwähnenswert, dass wir das Experiment im Juli 2025 durchführten – und in der kurzen Zeit seither haben sich bereits mehrere der Tools, die wir verwendeten, erheblich weiterentwickelt.

Auf der technischen Seite sind unsere wichtigsten Erkenntnisse:

- Komplexe, nicht-generische Prompts sind immer noch schwer

- Einfache, generische Szenarien können überzeugend generiert werden, mit atemberaubenden Visuals und starker Prompt-Adhärenz.

- ChatGPT ist ein echter Arbeitsesel für die Bilderstellung, übersetzt Referenzen in verwendbare Grundbilder und leitet einen iterativen Workflow.

- Photoshops Generative KI ist der Klebstoff, fixiert, erweitert und richtet Aufnahmen zu etwas Kohärentem aus.

- Higgsfield (Veo 3 mit seinem „Speak"-Feature) war überraschend zuverlässig für sprechende Charaktere, hielt Stimme und Identität konsistent.

- Stimmklonen erwies sich als machbar auch mit minimalen Daten, obwohl mehr Material eindeutig weit größere Nuancen freischalten würde.

- Natürlich klingende Erzählung war möglich mit der richtigen Mischung aus emotionalen Hinweisen, Timing-Anpassungen und manueller Bearbeitung.

- Vor allem bedeckte kein einzelnes Modell alles – Erfolg kam durch Tool-Stacking und starke referenzgetriebene Anleitung.

Aber die größere Erkenntnis war mehr kreativ als technisch. KI war nie der kreative Leiter – es war der Assistent. Die Visuals funktionierten nur, weil sie durch Recherche, Vorbereitung und eine klare kreative Vision gesteuert wurden. Jedes Bild erforderte immer noch Planung, Experimentieren und Entscheidungsfindung.

Also ja, KI kann die Produktion beschleunigen und große, „Hollywood-maßstäbliche" Konzepte plötzlich möglich erscheinen lassen. Aber es verlockt dich auch in ein Kaninchenloch des Perfektionismus – endlos nach der makellosen Aufnahme zu jagen, die vielleicht nie kommt. Die Disziplin liegt darin, zu wissen, wann man loslassen muss.

Der wahre Wert der KI, erkannten wir, liegt darin, wie sie menschliche Anleitung verstärkt. Es macht Dinge möglich, die einst enorme Planung auf der Produktionsseite und riesige Ressourcen in der Postproduktion erforderten. Manche Aufnahmen wären innerhalb der meisten Budgets überhaupt nicht machbar gewesen.

In diesem Sinne funktioniert KI wie eine Abkürzung – streift Schichten von Logistik ab und ermöglicht Szenarien, die sich wirklich einzigartig anfühlen. Aber der Kompromiss ist, dass es eine kristallklare Vision erfordert: wie das Ergebnis aussehen sollte, wie es sich anfühlen sollte und wie es Menschen emotional anziehen sollte.

Und während KI Zeit sparen kann, sind diese Produktionen alles andere als Ein-Klick-Wunder. Jede Sequenz braucht immer noch unzählige Iterationen, Schnitte und sorgfältige Anordnung, bevor sie überzeugend wird. Die Tools beschleunigen die Arbeit, aber das Handwerk bleibt darin, wie du sie steuerst, verfeinerst und zusammenfügst.

Das machte auch das Teilen des Ergebnisses mit dem Kunden so lohnend. Nach all den Experimenten, Tests und Neuschnitten waren wir neugierig, wie sie reagieren würden.

Und was sagten sie?

Sie waren wirklich erfreut, dass wir ihre Idee wieder aufgriffen und drängten, ihre Vision auf eine neue Weise real zu machen. Am Ende nahmen sie nicht nur das Ergebnis an, sondern bezahlten auch dafür – was bedeutete, dass das Projekt unsere Forschungskosten deckte und ihnen gleichzeitig ein frisches, unerwartetes Stück Storytelling gab.