Perspectivas del Proyecto: Cómo rendersnek Produjo un Anuncio Documental con IA

Descubre cómo rendersnek creó un concepto FOOH completo usando IA — desde entornos y personajes hasta narración — y qué pueden aprender los estudios de esto.

Un artículo invitado de rendersnek

Cada estudio de FOOH o CGI se ha enfrentado a este problema al menos una vez: un cliente llega con una idea tan grande, tan técnicamente ambiciosa, que casi roza una producción de Hollywood.

El año pasado, Kockum Sonics — una empresa suiza especializada en sistemas de alarma acústica — vino con una idea que, en ese momento, parecía demasiado ambiciosa para una producción clásica.

Este año, la situación había cambiado. Con una ola de nuevas herramientas de IA ahora en el mercado, tomas que antes se sentían “imposibles” de repente se volvieron alcanzables con una fracción del presupuesto. Así que revisitamos el concepto — no solo para cumplir con el brief, sino para usarlo como campo de pruebas para el pipeline de IA de vanguardia de hoy.

Convertimos su visión en un experimento completo: ¿podríamos construir un mini-documental completo con IA, desde entornos y personajes hasta narración y escenas de desastres? Y al final, sorprendimos al cliente con el resultado.

Sabíamos desde el principio que esta no era una tarea para una producción FOOH clásica, para la que normalmente nos contratan. Sin embargo, aún queríamos aceptarla. Así que se convirtió en un experimento abierto: ¿podría todo un concepto visual producirse exclusivamente con IA?

Lo que comenzó como un signo de interrogación se convirtió en un completo cortometraje de 30 segundos con IA — completo con entornos, personajes, escenas de desastres y un narrador auténtico que lleva la historia. Y así es como lo hicimos posible.

Fase 1: Investigación y Búsqueda de Referencias (Fundamentos para la Creación de Imágenes)

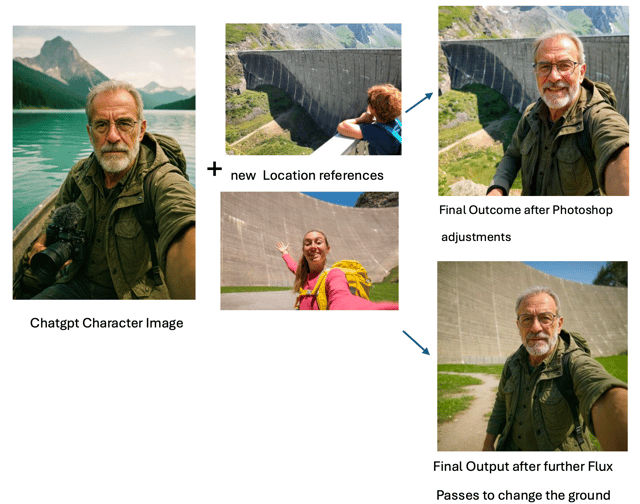

Primero, comenzamos con la búsqueda de referencias: embalses, arquitectura de presas, valles alpinos. La presa Kaprun en Austria sirvió como un ancla particularmente fuerte para escala y estructura.

Desde ahí, ChatGPT actuó como nuestro co-director de imagen. No le lanzamos descripciones de escenas completas de inmediato. En su lugar, trabajamos en iteraciones ajustadas: una pista visual a la vez, a menudo pausando para refinar antes de agregar el siguiente detalle — ya fuera óptica, ubicación o atmósfera.

En lugar de hacer un guion de todo fotograma por fotograma, ChatGPT nos ayudó a traducir estas referencias directamente en prompts de imagen. Ese proceso se convirtió en el motor para generar las primeras imágenes base utilizables.

Fase 2: Creación de Imágenes Base — Personajes y Entornos

Dos pilares impulsaron esta fase:

Un narrador estilo documental (tranquilo, inteligente, al aire libre) y

Las imágenes base ambientales (pared de presa, embalse, valle, líneas de bosque, perspectivas por debajo de la presa).

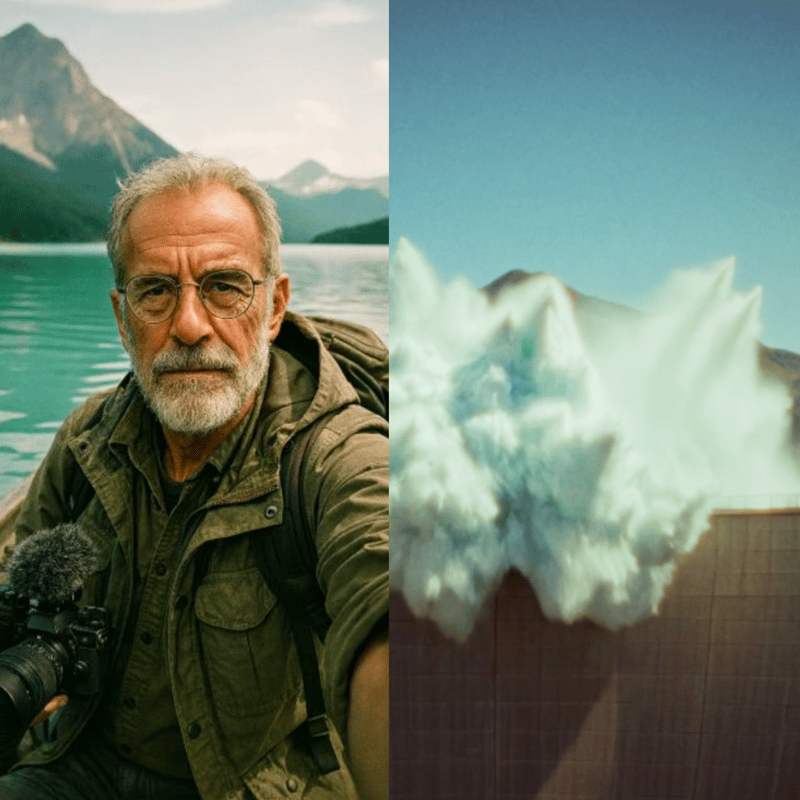

Para el personaje, el desafío era diseñar a alguien que se sintiera auténtico, una figura que pudiera llevar convincentemente una voz documental a través de múltiples escenas, mientras permanecía visualmente consistente. Comenzamos con referencias del mundo real: hombres mayores con gafas, barbas claras y ropa de exterior.

Desde ahí, construimos la persona a través de un diálogo iterativo de prompts con ChatGPT. Avanzando en pequeños pasos — pausando para “espera más instrucciones”, luego agregando nuevas pistas como ubicación u óptica de cámara — dimos forma a un narrador fotorrealista que nunca existió realmente, pero que instantáneamente proyectaba credibilidad y familiaridad.

Fragmentos de prompts utilizados en el camino (ejemplos):

“Orador documental clásico, hombre mayor 60—70, gafas de montura fina, barba clara, atuendo de explorador.”

“Hiper-fotorrealista, aspecto de película analógica — Kodak Portra 400, Zeiss 50 mm, Minolta XD1, ligero grano, retrato 3:4.”

“Se está filmando a sí mismo en perspectiva selfie en un bote de remos en el embalse, mirando a la cámara; coloca algo de equipo de exterior/cámara en el bote.”

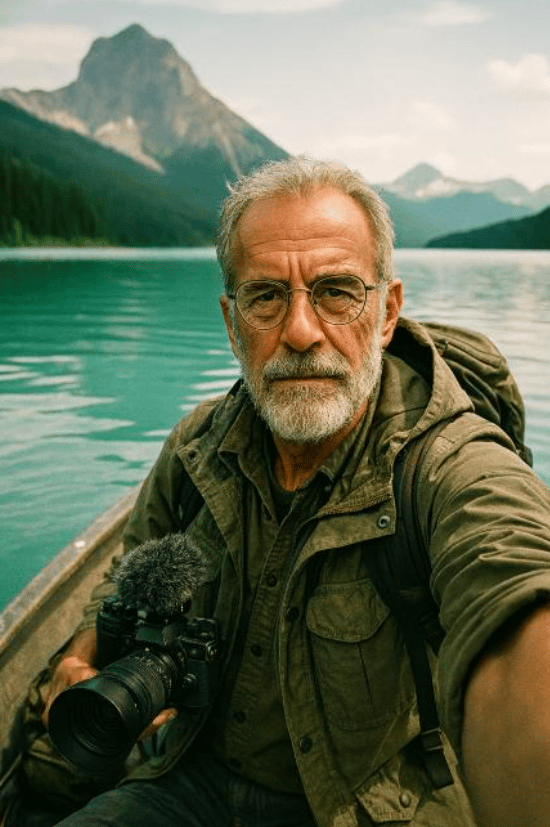

Los entornos requerían un tipo diferente de disciplina: tenían que permanecer geográficamente estables para que las secuencias de video posteriores se sintieran coherentes. La presa Kaprun en Austria se convirtió en un ancla clave para escala y estructura. Usando esta y otras referencias, ChatGPT generó una primera biblioteca de imágenes base — desde la pared de la presa y el embalse hasta perspectivas del valle abajo. La IA Generativa de Photoshop luego refinó y extendió estas salidas: corrigiendo fallas, expandiendo marcos a formatos cinematográficos e insertando pequeños detalles que definen identidad como cabañas o líneas de árboles para asegurar que cada configuración se viera auténtica y conectada.

Fase 3: Consistencia con el Modelo de Contexto Flux

Para ampliar y estabilizar la apariencia del narrador a través de configuraciones, usamos el modelo de contexto Flux para generar tomas fijas adicionales estilo vlog ancladas al retrato base. Cuando las salidas se desviaban (características, ropa, micro-estilo), las arreglamos ya sea en Photoshop o volviendo a ejecutar pases de Flux seleccionados hasta que el kit del personaje se sintiera sólido como una roca.

Fase 4: Vlogs Hablando con Higgsfield (Google Veo 3, “Speak”)

Con las tomas fijas del personaje listas, nos movimos a Higgsfield, que aprovecha Google Veo 3 y una herramienta “Speak” incorporada para personajes hablando (sincronización labial, micro-movimiento facial y audio).

Lo que funcionó bien en Higgsfield en la práctica:

- Consistencia de identidad de voz incluso a través de diferentes imágenes base del mismo personaje.

- Acoplamiento estrecho de audio y movimiento generado dentro de un flujo de trabajo (menos traspasos).

- Iteración rápida para contenido de talking-head — ideal para los segmentos de vlog que “toman de la mano al espectador” a través de la historia.

Ejemplo de prompt utilizado: “Este vlogger documental se para frente a una pared de presa en medio de la naturaleza serena y habla a sus espectadores con una voz tranquila y curiosa. Suena como un orador documental viejo.”

A través de tomas y configuraciones, el personaje retuvo la misma personalidad vocal y coherencia visual.

Fase 5: Cinematografía de Desastres con Kling 2.1 Master

Para acción cinematográfica y naturaleza, probamos Veo 2, Veo 3 y otros. Dentro de la suite de IA de Freepik, el claro ganador para las secuencias de desastres complejas fue Kling 2.1 Master. Fue el único modelo que, con suficiente iteración, pudo renderizar de manera creíble:

- un deslizamiento de tierra cayendo en un lago de montaña (0:16),

- la ola de inundación resultante amenazando el valle (0:23), y

- La sirena emitiendo pulsos similares a ondas de choque que encuentran y “neutralizan” la ola (la resolución literal de la película) (0:30).

Estos prompts eran altamente específicos y no genéricos; la mayoría de los modelos luchaban para analizarlos.

Kling no fue mágico desde el primer momento, pero nos dio bloques de construcción utilizables después de experimentación persistente.

Para apoyar el proceso de prompting, usamos el Freepik Prompt Enhancer, que ayudó a articular instrucciones visuales más precisamente — especialmente cuando el lenguaje correcto para un efecto de nicho era difícil de precisar.

Para secuencias más simples, Kling funcionó perfectamente con esfuerzo mínimo — que es de donde vinieron observaciones como “movimiento realista, transiciones de cámara suaves, alta adherencia a prompts, costo-efectivo” en primer lugar:

- tomas de establecimiento de la presa,

- perspectivas aéreas amplias,

- panorámicas suaves y comportamiento de cámara,

- iluminación natural convincente.

Esos fueron los lugares donde simplemente funcionó — rápida y limpiamente.

Prompt para producir la toma aérea:

“La cámara asciende lentamente, inclinándose hacia abajo mientras la vista transiciona a una perspectiva de ojo de pájaro sobre el lago sereno. La escena muestra la presa y las montañas circundantes en detalle vibrante, resaltando la belleza natural del paisaje.”

Fase 6: Clonación de Voz con ElevenLabs

Queríamos la misma voz de los vlogs de Higgsfield para una voz en off más larga que abarcara escenas. Comenzamos entrenando un clon de voz en ElevenLabs usando los pocos clips de Higgsfield disponibles (no óptimo por ningún medio). Idealmente, entrenarías a través del rango completo de una voz — diferentes emociones, ritmo, intensidad, entornos, etc.

Aun así, el clon fue sorprendentemente bueno dados los datos de entrenamiento limitados: timbre bastante consistente, la mayoría del tiempo reconociblemente el mismo narrador, y lo suficientemente bueno para llevar la voz en off de la película con algunos ajustes manuales menores aquí y allá. Con un conjunto de datos más amplio, esperaríamos mucha mayor nuance, rango dinámico y realismo.

Fase 7: Poniendo el clon a trabajar y descubriendo emoción narrativa

Ahora era tiempo de realmente producir la voz en off para la película usando el clon de voz recién creado. ChatGPT rápidamente creó un texto para el hablante, que después de algunos ajustes humanos por nuestro equipo creativo estaba listo para la voz en off.

Debido a que las generaciones tempranas se sentían bastante neutrales, profundizamos en las opciones de ElevenLabs y tácticas de scripting, investigando qué se podía hacer. ElevenLabs oficialmente recomienda colocar algún tipo de dirección narrativa después de la línea hablada en el guión:

p.ej., “Sirenas estacionarias”, dijo lenta y seriamente.

A través de pruebas, sin embargo, descubrimos que lo opuesto funcionaba mejor: colocar la pista emocional antes de la línea hablada. Por ejemplo:

Lenta y con gravedad, él explica: “Sirenas estacionarias.”

Este método aseguró que para el momento en que se hablara la línea, la voz IA ya estuviera “en personaje”. La desventaja general de las pistas narrativas: estas pistas iniciales tienen que ser cortadas manualmente después. La ventaja: la entrega es mucho, mucho más convincente.

Otras técnicas clave incluían:

- Usar marcadores <break time=“1.0s” /> para pausas precisas en lugar de confiar en puntuación.

- Ajustar la configuración de Estabilidad para balancear entre variación expresiva y tono consistente

La combinación de estos enfoques transformó la voz en off de robótica a narrativamente atractiva.

Fase 8: Ensamblaje Final y Sonido

El pase final reunió:

- Clips de vlog (Higgsfield / Veo 3 Speak),

- Secuencias de desastres y paisajes (Freepik Kling 2.1 Master),

- Imágenes base y visuales ambientales generadas principalmente con ChatGPT (luego refinadas vía IA Generativa de Photoshop y, para continuidad, el modelo de contexto Flux)

- Voz en off (clon ElevenLabs con narración con guión),

- Diseño de sonido, edición y timing (pulido manual con DaVinci Resolve, también incluye una herramienta de subtítulos automáticos, que usamos como línea base para timing).

La pieza terminada es un cortometraje cohesivo, completamente generado por IA — dirigido por humanos. Ejecutado por máquina y cortado y terminado manualmente.

Reflexiones y Aprendizajes

Mirando atrás, este proyecto nos mostró tanto las fortalezas como los límites del pipeline de IA de hoy. Vale la pena notar que condujimos el experimento en julio de 2025 — y en el corto tiempo desde entonces, varias de las herramientas que usamos ya han avanzado significativamente.

En el lado técnico, nuestros aprendizajes clave son:

- Los prompts complejos y no genéricos siguen siendo difíciles

- Los escenarios simples y genéricos pueden generarse convincentemente, con visuales impresionantes y fuerte adherencia a prompts.

- ChatGPT es un verdadero caballo de batalla para creación de imágenes, traduciendo referencias en imágenes base utilizables y guiando un flujo de trabajo iterativo.

- La IA Generativa de Photoshop es el pegamento, arreglando, extendiendo y alineando tomas en algo coherente.

- Higgsfield (Veo 3 con su función “Speak”) fue sorprendentemente confiable para personajes hablando, manteniendo voz e identidad consistentes.

- La clonación de voz resultó viable incluso con datos mínimos, aunque más material claramente desbloquearía mucha mayor nuance.

- La narración que suena natural fue posible con la mezcla correcta de pistas emocionales, ajustes de timing y edición manual.

- Por encima de todo, ningún modelo único cubrió todo — el éxito vino del apilamiento de herramientas y dirección fuerte basada en referencias.

Pero la realización más grande fue más creativa que técnica. La IA nunca fue el director creativo — fue el asistente. Los visuales solo funcionaron porque fueron guiados por investigación, preparación y una visión creativa clara. Cada fotograma aún requirió planificación, experimentación y toma de decisiones.

Así que sí, la IA puede acelerar la producción y hacer que conceptos grandes, “a escala de Hollywood” de repente se sientan posibles. Pero también te tienta hacia un agujero de conejo de perfeccionismo — persiguiendo infinitamente la toma perfecta que puede nunca llegar. La disciplina radica en saber cuándo soltar.

El valor real de la IA, nos dimos cuenta, radica en cómo amplifica la dirección humana. Hace posibles cosas que antes demandaban planificación enorme en el lado de producción y vastos recursos en postproducción. Algunas tomas no habrían sido factibles en absoluto dentro de la mayoría de presupuestos.

En ese sentido, la IA funciona como un atajo — despojando capas de logística y habilitando escenarios que se sienten verdaderamente únicos. Pero el compromiso es que requiere una visión cristalina: cómo debería verse el resultado, cómo debería sentirse, y cómo debería atraer a las personas emocionalmente.

Y mientras la IA puede ahorrar tiempo, estas producciones están lejos de ser maravillas de un clic. Cada secuencia aún toma incontables iteraciones, cortes y arreglo cuidadoso antes de que se vuelva convincente. Las herramientas aceleran el trabajo, pero el oficio permanece en cómo las diriges, refinas y ensamblas.

Eso también es lo que hizo tan gratificante compartir el resultado con el cliente. Después de todos los experimentos, pruebas y re-cortes, teníamos curiosidad sobre cómo responderían.

¿Y qué dijeron?

Estaban genuinamente complacidos de que revisitáramos su idea y lucháramos para hacer su visión real de una nueva manera. Al final, no solo abrazaron el resultado sino que también pagaron por él — lo que significó que el proyecto cubrió nuestros costos de investigación mientras les daba una pieza fresca e inesperada de narración.