Aperçus du projet : Comment rendersnek a produit une publicité documentaire avec l'IA

Découvre comment rendersnek a créé un concept FOOH complet en utilisant l'IA — des environnements et personnages à la narration — et ce que les studios peuvent en apprendre.

Un article invité par rendersnek

Tous les studios FOOH ou CGI ont été confrontés à ce problème au moins une fois : un client arrive avec une idée si grande, si techniquement ambitieuse, qu’elle frôle presque une production hollywoodienne.

L’année dernière, Kockum Sonics — une entreprise suisse spécialisée dans les systèmes d’alarme acoustique — est venue avec une idée qui, à l’époque, semblait trop ambitieuse pour une production classique.

Cette année, la situation a changé. Avec une vague de nouveaux outils IA maintenant sur le marché, des plans qui semblaient autrefois « impossibles » sont soudainement devenus réalisables avec une fraction du budget. Alors nous avons revisité le concept — non seulement pour répondre au brief, mais pour l’utiliser comme banc d’essai pour le pipeline IA de pointe d’aujourd’hui.

Nous avons transformé leur vision en une expérience complète : pourrions-nous construire un mini-documentaire entier avec l’IA, des environnements et personnages à la narration et aux scènes de catastrophe ? Et à la toute fin, nous avons surpris le client avec le résultat.

Nous savions dès le début que ce n’était pas une tâche pour une production FOOH classique, pour laquelle nous sommes habituellement engagés. Pourtant, nous voulions toujours l’entreprendre. C’est donc devenu une expérience ouverte : un concept visuel entier pouvait-il être produit exclusivement avec l’IA ?

Ce qui a commencé comme un point d’interrogation s’est transformé en 30 secondes entièrement réalisées avec l’IA — avec des environnements, des personnages, des scènes de catastrophe et un narrateur authentique portant l’histoire. Et voici comment nous l’avons fait.

Phase 1 : Recherche et sourcing de références (fondations pour la création d’images)

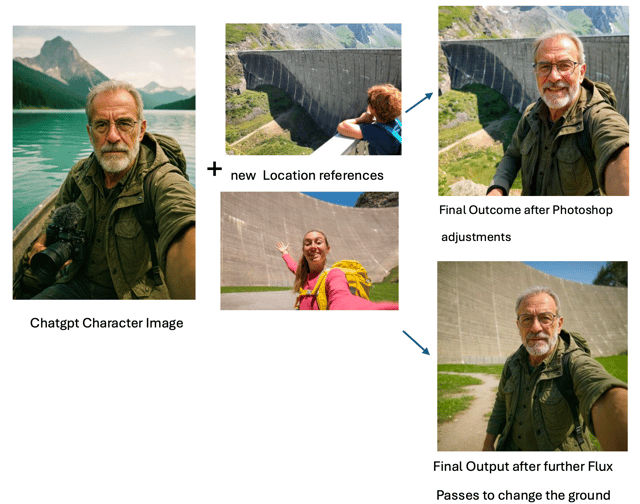

D’abord, nous avons commencé par la chasse aux références : réservoirs, architecture de barrage, vallées alpines. Le barrage de Kaprun en Autriche a servi d’ancre particulièrement solide pour l’échelle et la structure.

De là, ChatGPT a agi comme notre co-directeur d’images. Nous n’avons pas lancé des descriptions de scènes complètes tout de suite. Au lieu de cela, nous avons travaillé en itérations serrées : un indice visuel à la fois, nous arrêtant souvent pour affiner avant d’ajouter le détail suivant — que ce soit l’optique, l’emplacement ou l’atmosphère.

Plutôt que de scripter tout image par image, ChatGPT nous a aidés à traduire ces références directement en prompts d’images. Ce processus est devenu le moteur pour générer les premières images de base utilisables.

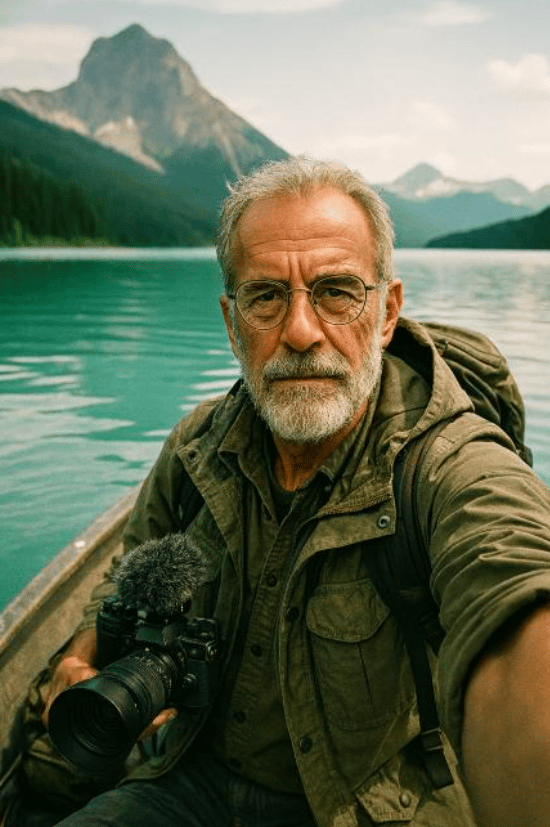

Phase 2 : Création d’images de base — Personnages et environnements

Deux piliers ont guidé cette phase :

un narrateur de style documentaire (calme, intelligent, en extérieur) et

les images de base environnementales (mur de barrage, réservoir, vallée, lignes forestières, perspectives sous le barrage).

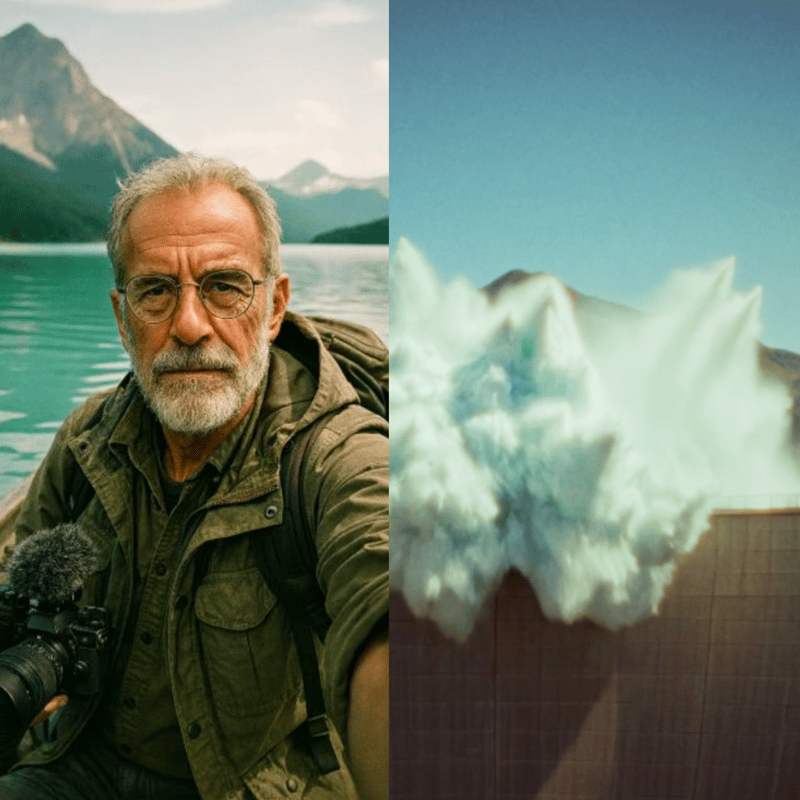

Pour le personnage, le défi était de concevoir quelqu’un qui semblait authentique, une figure qui pouvait porter de manière convaincante une voix documentaire à travers plusieurs scènes, tout en restant visuellement cohérente. Nous avons commencé avec des références du monde réel : hommes âgés avec des lunettes, barbes claires et vêtements d’extérieur.

De là, nous avons construit le personnage à travers un dialogue de prompt itératif avec ChatGPT. En avançant par petites étapes — nous arrêtant pour « attendre d’autres instructions », puis superposant de nouveaux indices comme l’emplacement ou l’optique de caméra — nous avons façonné un narrateur photoréaliste qui n’a jamais vraiment existé, mais qui projetait instantanément crédibilité et familiarité.

Fragments de prompt utilisés en cours de route (exemples) :

« Orateur documentaire classique, homme âgé 60—70 ans, lunettes à monture fine, barbe claire, tenue d’explorateur. »

« Hyper-photoréaliste, look film analogique — Kodak Portra 400, Zeiss 50 mm, Minolta XD1, léger grain, portrait 3:4. »

« Il se filme en perspective selfie sur un bateau à rames dans le réservoir, regardant la caméra ; place quelques équipements d’extérieur/caméra dans le bateau. »

Les environnements nécessitaient un type de discipline différent : ils devaient rester géographiquement stables pour que les séquences vidéo ultérieures semblent cohérentes. Le barrage de Kaprun en Autriche est devenu une ancre clé pour l’échelle et la structure. En utilisant cette référence et d’autres, ChatGPT a généré une première bibliothèque d’images de base — du mur de barrage et du réservoir aux perspectives de vallée en contrebas. L’IA générative de Photoshop a ensuite affiné et étendu ces sorties : corrigeant les défauts, élargissant les cadres aux formats cinématographiques, et insérant de petits détails définissant l’identité comme des cabanes ou des lignes d’arbres pour s’assurer que chaque décor semblait authentique et connecté.

Phase 3 : Cohérence avec le modèle de contexte Flux

Pour élargir et stabiliser l’apparence du narrateur à travers les décors, nous avons utilisé le modèle de contexte Flux pour générer des plans fixes supplémentaires de style vlog ancrés au portrait de base. Quand les sorties déviaient (traits, vêtements, micro-style), nous les avons corrigées soit dans Photoshop soit en relançant des passes Flux sélectionnées jusqu’à ce que le kit de personnage semble verrouillé solidement.

Phase 4 : Vlogs parlants avec Higgsfield (Google Veo 3, « Speak »)

Avec les images fixes de personnage prêtes, nous sommes passés à Higgsfield, qui exploite Google Veo 3 et un outil « Speak » intégré pour les personnages parlants (synchronisation labiale, micro-mouvement facial et audio).

Ce qui a bien fonctionné sur Higgsfield en pratique :

- Cohérence de l’identité vocale même à travers différentes images de base du même personnage.

- Couplage serré de l’audio et du mouvement généré dans un seul workflow (moins de transferts).

- Itération rapide pour le contenu de talking-head — idéal pour les segments vlog qui « prennent le spectateur par la main » à travers l’histoire.

Exemple de prompt utilisé : « Ce vloggeur documentaire se tient devant un mur de barrage au milieu d’une nature sereine et parle à ses spectateurs d’une voix calme et curieuse. Il sonne comme un ancien orateur de documentaire. »

À travers les prises et les décors, le personnage a conservé la même personnalité vocale et cohérence visuelle.

Phase 5 : Cinématographie de catastrophe avec Kling 2.1 Master

Pour l’action cinématographique et la nature, nous avons testé Veo 2, Veo 3 et d’autres. Dans la suite IA de Freepik, le gagnant clair pour les séquences de catastrophe complexes était Kling 2.1 Master. C’était le seul modèle qui, avec suffisamment d’itération, pouvait rendre de manière crédible :

- un glissement de terrain cascadant dans un lac de montagne (0:16),

- la vague d’inondation qui s’ensuit menaçant la vallée (0:23), et

- La sirène émettant des impulsions semblables à des ondes de choc qui rencontrent et « neutralisent » la vague (la résolution littérale du film) (0:30).

Ces prompts étaient hautement spécifiques et non génériques ; la plupart des modèles ont eu du mal à les analyser.

Kling n’était pas magique prêt à l’emploi, mais il nous a donné des blocs de construction utilisables après une expérimentation persistante.

Pour soutenir le processus de prompt, nous avons utilisé l’Améliorateur de Prompt Freepik, qui a aidé à articuler les instructions visuelles plus précisément — surtout quand le bon langage pour un effet de niche était difficile à cerner.

Pour les séquences plus simples, Kling a performé parfaitement avec un effort minimal — c’est là que des observations comme « mouvement réaliste, transitions de caméra fluides, haute adhérence au prompt, rentable » sont venues en premier lieu :

- plans d’établissement du barrage,

- perspectives aériennes larges,

- panoramiques fluides et comportement de caméra,

- éclairage naturel convaincant.

C’étaient les endroits où ça marchait simplement — rapidement et proprement.

Prompt pour produire le plan aérien :

« La caméra s’élève lentement, s’inclinant vers le bas alors que la vue passe à une perspective à vol d’oiseau sur le lac serein. La scène met en valeur le barrage et les montagnes environnantes avec des détails vibrants, soulignant la beauté naturelle du paysage. »

Phase 6 : Clonage vocal avec ElevenLabs

Nous voulions la même voix des vlogs Higgsfield pour une voix off plus longue, s’étendant sur les scènes. Nous avons commencé à entraîner un clone vocal sur ElevenLabs en utilisant les quelques clips Higgsfield disponibles (pas optimal du tout). Idéalement, tu entraînerais sur toute la gamme d’une voix — différentes émotions, rythmes, intensité, environnements et ainsi de suite.

Même ainsi, le clone était étonnamment bon compte tenu des données d’entraînement limitées : timbre assez cohérent, la plupart du temps reconnaissablement le même narrateur, et assez bon pour porter la voix off du film avec quelques ajustements manuels mineurs ici et là. Avec un dataset plus large, nous nous attendrions à beaucoup plus de nuance, de gamme dynamique et de réalisme.

Phase 7 : Mettre le clone au travail et comprendre l’émotion narrationnelle

Il était maintenant temps de produire réellement la voix off pour le film en utilisant le clone vocal nouvellement créé. ChatGPT a rapidement proposé un texte pour l’orateur, qui après quelques ajustements humains par notre équipe créative était bon à partir pour la voix off.

Parce que les premières générations semblaient plutôt neutres, nous avons creusé dans les options d’ElevenLabs et les tactiques de script, recherchant ce qui pouvait être fait. ElevenLabs recommande officiellement de placer une sorte de direction narrative après la ligne parlée dans le script :

ex., « Sirènes stationnaires », dit-il lentement et sérieusement.

À travers les tests, cependant, nous avons découvert que l’opposé fonctionnait mieux : placer l’indice émotionnel avant la ligne parlée. Par exemple :

Lentement et avec gravité, il explique : « Sirènes stationnaires. »

Cette méthode s’assurait qu’au moment où la ligne était prononcée, la voix IA était déjà « dans le personnage ». L’inconvénient général des indices narrationnels : ces indices principaux doivent être coupés manuellement après. L’avantage : la livraison est beaucoup beaucoup plus convaincante.

D’autres techniques clés comprenaient :

- Utiliser des marqueurs <break time=“1.0s” /> pour des pauses précises au lieu de compter sur la ponctuation.

- Ajuster le paramètre de Stabilité pour équilibrer entre variation expressive et ton cohérent

La combinaison de ces approches a transformé la voix off de robotique à narrativement engageante.

Phase 8 : Assemblage final et son

Le passage final a rassemblé :

- Clips de vlog (Higgsfield / Veo 3 Speak),

- Séquences de catastrophe et de paysage (Freepik Kling 2.1 Master),

- Images de base et visuels environnementaux générés principalement avec ChatGPT (puis affinés via l’IA générative de Photoshop et, pour la continuité, le modèle de contexte Flux)

- Voix off (clone ElevenLabs avec narration scriptée),

- Design sonore, montage et timing (Polish manuel avec Davinci Resolve, inclut aussi un outil de sous-titrage automatique, que nous avons utilisé comme base pour le timing).

La pièce finie est un court entièrement généré par IA cohérent — dirigé par l’humain. Exécuté par la machine et coupé et fini manuellement.

Réflexions et apprentissages

En regardant en arrière, ce projet nous a montré à la fois les forces et les limites du pipeline IA d’aujourd’hui. Il vaut la peine de noter que nous avons mené l’expérience en juillet 2025 — et dans le peu de temps depuis, plusieurs des outils que nous avons utilisés ont déjà avancé significativement.

Du côté technique, nos apprentissages clés sont :

- Les prompts complexes et non génériques sont encore difficiles

- Les scénarios simples et génériques peuvent être générés de manière convaincante, avec des visuels époustouflants et une forte adhérence au prompt.

- ChatGPT est un vrai cheval de bataille pour la création d’images, traduisant les références en images de base utilisables et guidant un workflow itératif.

- L’IA générative de Photoshop est la colle, corrigeant, étendant et alignant les plans en quelque chose de cohérent.

- Higgsfield (Veo 3 avec sa fonctionnalité « Speak ») était étonnamment fiable pour les personnages parlants, gardant la voix et l’identité cohérentes.

- Le clonage vocal s’est avéré viable même avec des données minimales, bien que plus de matériel débloquerait clairement beaucoup plus de nuance.

- Une narration au son naturel était possible avec le bon mélange d’indices émotionnels, d’ajustements de timing et de montage manuel.

- Surtout, aucun modèle unique ne couvrait tout — le succès venait de l’empilement d’outils et d’une forte direction guidée par les références.

Mais la réalisation plus importante était plus créative que technique. L’IA n’a jamais été le directeur créatif — c’était l’assistant. Les visuels n’ont fonctionné que parce qu’ils étaient guidés par la recherche, la préparation et une vision créative claire. Chaque image nécessitait encore planification, expérimentation et prise de décision.

Donc oui, l’IA peut accélérer la production et faire que de grands concepts « à l’échelle d’Hollywood » semblent soudainement possibles. Mais elle te tente aussi dans un terrier de lapin de perfectionnisme — poursuivant sans fin le plan parfait qui pourrait ne jamais venir. La discipline réside dans savoir quand lâcher prise.

La vraie valeur de l’IA, nous avons réalisé, réside dans comment elle amplifie la direction humaine. Elle rend possibles des choses qui demandaient autrefois une planification énorme du côté production et de vastes ressources en postproduction. Certains plans n’auraient pas été faisables du tout dans la plupart des budgets.

En ce sens, l’IA fonctionne comme un raccourci — supprimant des couches de logistique et permettant des scénarios qui semblent vraiment uniques. Mais le compromis est qu’elle nécessite une vision cristalline : à quoi le résultat devrait ressembler, comment il devrait se sentir, et comment il devrait attirer les gens émotionnellement.

Et bien que l’IA puisse faire gagner du temps, ces productions sont loin d’être des merveilles à un clic. Chaque séquence prend encore d’innombrables itérations, coupes et arrangements soigneux avant de devenir convaincante. Les outils accélèrent le travail, mais l’artisanat reste dans comment tu diriges, affines et les assembles.

C’est aussi ce qui a rendu le partage du résultat avec le client si gratifiant. Après toutes les expériences, tests et re-coupes, nous étions curieux de savoir comment ils réagiraient.

Et qu’ont-ils dit ?

Ils étaient vraiment contents que nous ayons revisité leur idée et poussé pour rendre leur vision réelle d’une nouvelle manière. À la fin, ils ont non seulement embrassé le résultat mais ont aussi payé pour le résultat — ce qui signifiait que le projet couvrait nos coûts de recherche tout en leur donnant une pièce de storytelling fraîche et inattendue.