Approfondimenti del progetto: Come rendersnek ha prodotto una pubblicità in stile documentario con l'IA

Scopri come rendersnek ha creato un concetto FOOH completo usando l'IA — dagli ambienti e personaggi alla narrazione — e cosa i studios possono imparare da questo.

Un articolo ospite di rendersnek

Ogni studio FOOH o CGI ha affrontato questo problema almeno una volta: un cliente entra con un’idea così grande, così tecnicamente ambiziosa, che sfiora quasi una produzione hollywoodiana.

L’anno scorso, Kockum Sonics — un’azienda svizzera specializzata in sistemi di allarme acustici — è arrivata con un’idea che, a quel tempo, sembrava troppo ambiziosa per una produzione classica.

Quest’anno, la situazione è cambiata. Con un’ondata di nuovi strumenti IA ora sul mercato, inquadrature che una volta sembravano “impossibili” sono diventate improvvisamente realizzabili con una frazione del budget. Quindi abbiamo rivisitato il concetto — non solo per soddisfare il brief, ma per usarlo come banco di prova per la pipeline IA all’avanguardia di oggi.

Abbiamo trasformato la loro visione in un esperimento completo: potremmo costruire un intero mini-documentario con l’IA, dagli ambienti e personaggi alla narrazione e alle scene di disastro? E alla fine, abbiamo sorpreso il cliente con il risultato.

Sapevamo fin dall’inizio che questo non era un compito per una produzione FOOH classica, per cui di solito veniamo ingaggiati. Tuttavia volevamo ancora accettarlo. Quindi è diventato un esperimento aperto: un intero concetto visivo poteva essere prodotto esclusivamente con l’IA?

Quello che è iniziato come un punto interrogativo si è trasformato in 30 secondi completamente realizzati con l’IA — completi di ambienti, personaggi, scene di disastro e un narratore autentico che porta la storia. Ed è così che l’abbiamo fatto.

Fase 1: Ricerca e raccolta di riferimenti (fondamenta per la creazione di immagini)

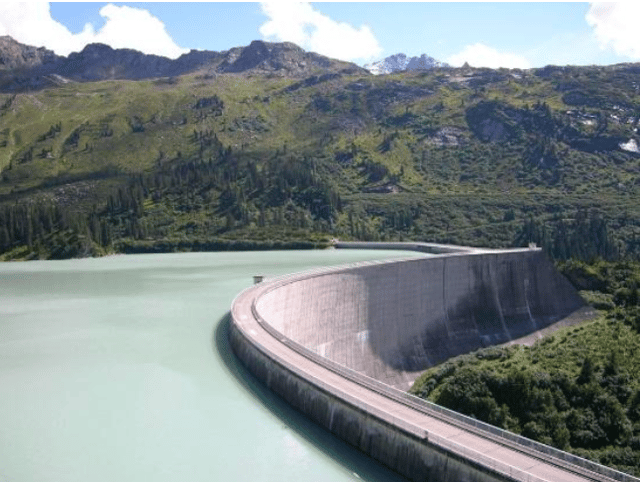

Prima, abbiamo iniziato con la caccia ai riferimenti: bacini, architettura di dighe, valli alpine. La diga di Kaprun in Austria è servita come ancora particolarmente forte per scala e struttura.

Da lì, ChatGPT ha agito come il nostro co-direttore di immagini. Non abbiamo lanciato descrizioni complete di scene subito. Invece, abbiamo lavorato in iterazioni strette: un indizio visivo alla volta, spesso fermandoci per perfezionare prima di aggiungere il dettaglio successivo — che fosse ottica, posizione o atmosfera.

Piuttosto che sceneggiare tutto fotogramma per fotogramma, ChatGPT ci ha aiutato a tradurre questi riferimenti direttamente in prompt per immagini. Quel processo è diventato il motore per generare le prime immagini base utilizzabili.

Fase 2: Creazione di immagini base — Personaggi e ambienti

Due pilastri hanno guidato questa fase:

un narratore in stile documentario (calmo, intelligente, all’aperto) e

le immagini base ambientali (muro della diga, bacino, valle, linee forestali, prospettive sotto la diga).

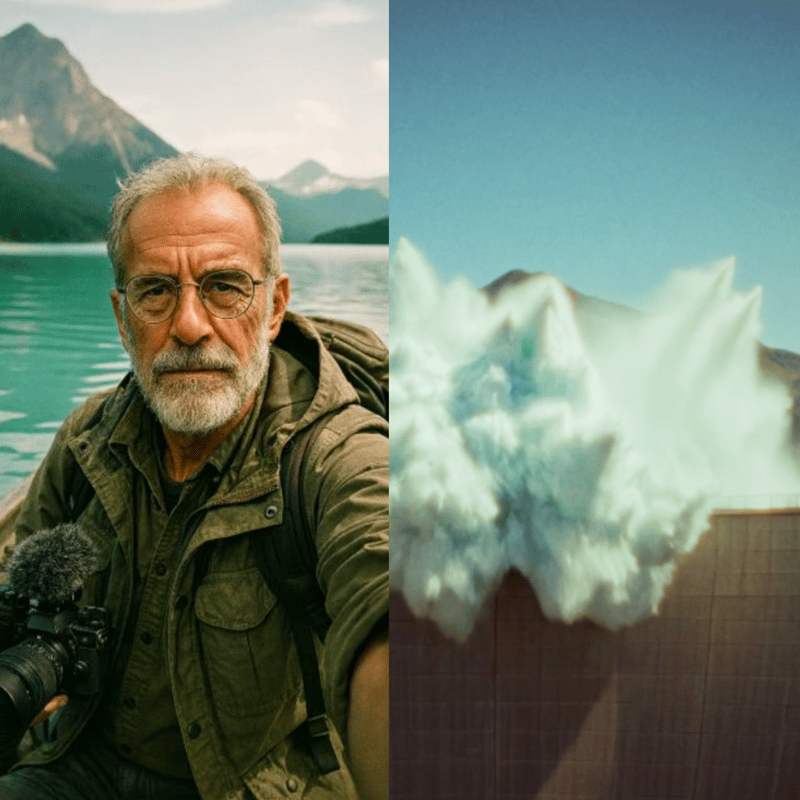

Per il personaggio, la sfida era progettare qualcuno che sembrasse autentico, una figura che potesse portare in modo convincente una voce documentaristica attraverso più scene, rimanendo visivamente coerente. Abbiamo iniziato con riferimenti del mondo reale: uomini anziani con occhiali, barbe chiare e abbigliamento da esterno.

Da lì, abbiamo costruito la persona attraverso un dialogo iterativo di prompt con ChatGPT. Muovendoci a piccoli passi — fermandoci per “attendere ulteriori istruzioni”, poi stratificando nuovi indizi come posizione o ottiche della telecamera — abbiamo modellato un narratore fotorealistico che non è mai esistito davvero, ma che proiettava istantaneamente credibilità e familiarità.

Frammenti di prompt usati lungo il percorso (esempi):

“Oratore documentaristico classico, maschio anziano 60—70 anni, occhiali con montatura sottile, barba chiara, outfit da esploratore.”

“Iper-fotorealistico, look cinematografico analogico — Kodak Portra 400, Zeiss 50 mm, Minolta XD1, grana leggera, ritratto 3:4.”

“Si sta filmando in prospettiva selfie su una barca a remi nel bacino, guardando nella telecamera; metti alcuni attrezzi da esterno/telecamera nella barca.”

Gli ambienti richiedevano un tipo diverso di disciplina: dovevano rimanere geograficamente stabili così che le sequenze video successive sembrassero coerenti. La diga di Kaprun in Austria è diventata un’ancora chiave per scala e struttura. Usando questo e altri riferimenti, ChatGPT ha generato una prima biblioteca di immagini base — dal muro della diga e il bacino alle prospettive della valle sottostante. L’IA generativa di Photoshop ha poi raffinato ed esteso questi output: correggendo difetti, espandendo i fotogrammi in formati cinematografici, e inserendo piccoli dettagli che definiscono l’identità come capanne o linee di alberi per assicurarsi che ogni ambientazione sembrasse autentica e connessa.

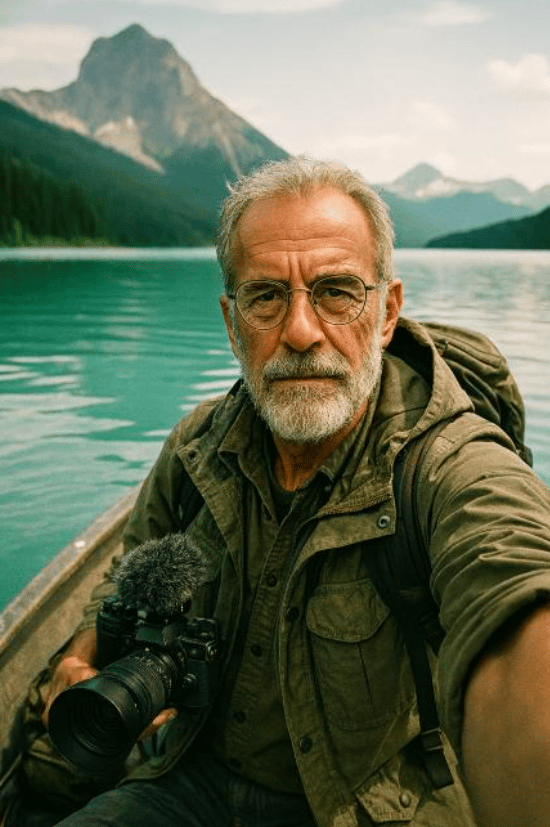

Fase 3: Coerenza con il modello di contesto Flux

Per ampliare e stabilizzare l’aspetto del narratore attraverso le ambientazioni, abbiamo usato il modello di contesto Flux per generare ulteriori immagini fisse in stile vlog ancorate al ritratto base. Quando gli output deviavano (caratteristiche, abbigliamento, micro-stile), li abbiamo corretti sia in Photoshop che rilanciando passaggi Flux selezionati finché il kit del personaggio non sembrava solidamente bloccato.

Fase 4: Vlog parlanti con Higgsfield (Google Veo 3, “Speak”)

Con le immagini fisse del personaggio pronte, siamo passati a Higgsfield, che sfrutta Google Veo 3 e uno strumento “Speak” integrato per personaggi parlanti (sincronizzazione labiale, micro-movimento facciale e audio).

Cosa ha funzionato bene su Higgsfield in pratica:

- Coerenza dell’identità vocale anche attraverso diverse immagini base dello stesso personaggio.

- Accoppiamento stretto di audio e movimento generato all’interno di un workflow (meno passaggi di mano).

- Iterazione veloce per contenuto talking-head — ideale per i segmenti vlog che “prendono per mano lo spettatore” attraverso la storia.

Esempio di prompt usato: “Questo vlogger documentaristico sta davanti a un muro di diga in mezzo alla natura serena e parla ai suoi spettatori con una voce calma e curiosa. Suona come un vecchio oratore documentaristico.”

Attraverso riprese e ambientazioni, il personaggio ha mantenuto la stessa personalità vocale e coerenza visiva.

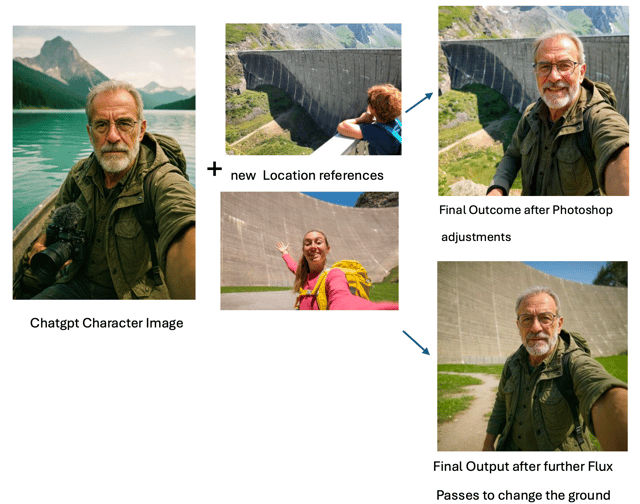

Fase 5: Cinematografia di disastri con Kling 2.1 Master

Per l’azione cinematografica e la natura, abbiamo testato Veo 2, Veo 3 e altri. All’interno della suite IA di Freepik, il chiaro vincitore per le sequenze di disastri complessi era Kling 2.1 Master. Era l’unico modello che, con abbastanza iterazione, poteva rendere credibilmente:

- una frana che precipita in un lago di montagna (0:16),

- l’onda di inondazione che ne consegue minacciando la valle (0:23), e

- La sirena che emette impulsi simili a onde d’urto che incontrano e “neutralizzano” l’onda (la risoluzione letterale del film) (0:30).

Questi prompt erano altamente specifici e non generici; la maggior parte dei modelli ha faticato a interpretarli.

Kling non era magico subito, ma ci ha dato blocchi di costruzione utilizzabili dopo una sperimentazione persistente.

Per supportare il processo di prompting, abbiamo usato il Freepik Prompt Enhancer, che ha aiutato ad articolare istruzioni visuali più precisamente — specialmente quando il linguaggio giusto per un effetto di nicchia era difficile da individuare.

Per sequenze più semplici, Kling ha performato perfettamente con sforzo minimo — che è da dove osservazioni come “movimento realistico, transizioni di telecamera fluide, alta aderenza al prompt, conveniente” sono venute in primo luogo:

- inquadrature di stabilimento della diga,

- prospettive aeree ampie,

- panoramiche fluide e comportamento della telecamera,

- illuminazione naturale convincente.

Quelli erano i posti dove semplicemente funzionava — rapidamente e in modo pulito.

Prompt per produrre l’inquadratura aerea:

“La telecamera sale lentamente, inclinandosi verso il basso mentre la vista passa a una prospettiva a volo d’uccello sul lago sereno. La scena mostra la diga e le montagne circostanti con dettagli vivaci, evidenziando la bellezza naturale del paesaggio.”

Fase 6: Clonazione vocale con ElevenLabs

Volevamo la stessa voce dai vlog Higgsfield per una voce fuori campo più lunga, che attraversasse le scene. Abbiamo iniziato ad allenare un clone vocale su ElevenLabs usando i pochi clip Higgsfield disponibili (non ottimale per niente). Idealmente, alleneresti su tutta la gamma di una voce — diverse emozioni, ritmi, intensità, ambienti e così via.

Anche così, il clone era sorprendentemente buono considerati i dati di allenamento limitati: timbro abbastanza coerente, per la maggior parte del tempo riconoscibilmente lo stesso narratore, e abbastanza buono per portare la voce fuori campo del film con alcuni aggiustamenti manuali minori qua e là. Con un dataset più ampio, ci aspetteremmo molto più sfumature, gamma dinamica e realismo.

Fase 7: Mettere il clone al lavoro e capire l’emozione narrativa

Era ora il momento di produrre effettivamente la voce fuori campo per il film usando il clone vocale appena creato. ChatGPT ha rapidamente proposto un testo per l’oratore, che dopo alcuni aggiustamenti umani dal nostro team creativo era pronto per la voce fuori campo.

Poiché le prime generazioni sembravano piuttosto neutrali, abbiamo scavato nelle opzioni di ElevenLabs e nelle tattiche di scripting, ricercando cosa si potesse fare. ElevenLabs raccomanda ufficialmente di posizionare una sorta di direzione narrativa dopo la linea parlata nello script:

ad es., “Sirene stazionarie,” disse lentamente e seriamente.

Attraverso i test, tuttavia, abbiamo scoperto che funzionava meglio l’opposto: posizionare l’indizio emotivo prima della linea parlata. Per esempio:

Lentamente e con gravità, spiega: “Sirene stazionarie.”

Questo metodo assicurava che al momento in cui la linea veniva pronunciata, la voce IA fosse già “nel personaggio”. Lo svantaggio generale degli indizi narrativi: questi indizi iniziali devono essere tagliati manualmente dopo. Il vantaggio: la consegna è molto molto più convincente.

Altre tecniche chiave includevano:

- Usare marcatori <break time=“1.0s” /> per pause precise invece di affidarsi alla punteggiatura.

- Regolare l’impostazione Stabilità per bilanciare tra variazione espressiva e tono coerente

La combinazione di questi approcci ha trasformato la voce fuori campo da robotica a narrativamente coinvolgente.

Fase 8: Assemblaggio finale e suono

Il passaggio finale ha riunito:

- Clip vlog (Higgsfield / Veo 3 Speak),

- Sequenze di disastri e paesaggi (Freepik Kling 2.1 Master),

- Immagini base e visuali ambientali generate principalmente con ChatGPT (poi raffinate tramite l’IA generativa di Photoshop e, per continuità, il modello di contesto Flux)

- Voce fuori campo (clone ElevenLabs con narrazione scritta),

- Design del suono, editing e timing (Rifinitura manuale con Davinci Resolve, include anche uno strumento di sottotitolazione automatica, che abbiamo usato come baseline per il timing).

Il pezzo finito è un cortometraggio coerente e completamente generato dall’IA — diretto dall’uomo. Eseguito dalla macchina e tagliato e rifinito manualmente.

Riflessioni e apprendimenti

Guardando indietro, questo progetto ci ha mostrato sia i punti di forza che i limiti della pipeline IA di oggi. Vale la pena notare che abbiamo condotto l’esperimento nel luglio 2025 — e nel breve tempo da allora, molti degli strumenti che abbiamo usato sono già avanzati significativamente.

Dal lato tecnico, i nostri apprendimenti chiave sono:

- I prompt complessi e non generici sono ancora difficili

- Gli scenari semplici e generici possono essere generati in modo convincente, con visuali stupefacenti e forte aderenza al prompt.

- ChatGPT è un vero cavallo da battaglia per la creazione di immagini, traducendo i riferimenti in immagini base utilizzabili e guidando un workflow iterativo.

- L’IA generativa di Photoshop è la colla, correggendo, estendendo e allineando le inquadrature in qualcosa di coerente.

- Higgsfield (Veo 3 con la sua funzione “Speak”) era sorprendentemente affidabile per i personaggi parlanti, mantenendo voce e identità coerenti.

- La clonazione vocale si è dimostrata fattibile anche con dati minimi, anche se più materiale sbloccherebbe chiaramente molto più sfumature.

- Una narrazione dal suono naturale era possibile con il giusto mix di indizi emotivi, aggiustamenti di timing ed editing manuale.

- Soprattutto, nessun singolo modello copriva tutto — il successo veniva dall’impilamento di strumenti e dalla forte direzione guidata dai riferimenti.

Ma la realizzazione più grande era più creativa che tecnica. L’IA non è mai stata il direttore creativo — era l’assistente. I visuali hanno funzionato solo perché erano guidati da ricerca, preparazione e una visione creativa chiara. Ogni fotogramma richiedeva ancora pianificazione, sperimentazione e presa di decisioni.

Quindi sì, l’IA può accelerare la produzione e far sembrare improvvisamente possibili concetti grandi, “di scala hollywoodiana”. Ma ti tenta anche in una tana del coniglio di perfezionismo — inseguendo all’infinito l’inquadratura perfetta che potrebbe non arrivare mai. La disciplina sta nel sapere quando lasciare andare.

Il valore reale dell’IA, abbiamo capito, sta in come amplifica la direzione umana. Rende possibili cose che una volta richiedevano enorme pianificazione sul lato produzione e vaste risorse in postproduzione. Alcune inquadrature non sarebbero state fattibili affatto con la maggior parte dei budget.

In quel senso, l’IA funziona come una scorciatoia — rimuovendo strati di logistica e abilitando scenari che sembrano davvero unici. Ma il compromesso è che richiede una visione cristallina: come dovrebbe apparire il risultato, come dovrebbe sentirsi, e come dovrebbe attirare le persone emotivamente.

E mentre l’IA può far risparmiare tempo, queste produzioni sono lontane dall’essere meraviglie a un clic. Ogni sequenza richiede ancora innumerevoli iterazioni, tagli e arrangiamenti attenti prima di diventare convincente. Gli strumenti accelerano il lavoro, ma l’artigianalità rimane in come li guidi, raffini e assembli.

È anche quello che ha reso così gratificante condividere il risultato con il cliente. Dopo tutti gli esperimenti, test e ri-tagli, eravamo curiosi di come avrebbero reagito.

E cosa hanno detto?

Erano genuinamente contenti che avessimo rivisitato la loro idea e spinto per rendere reale la loro visione in un modo nuovo. Alla fine, non solo hanno abbracciato il risultato ma hanno anche pagato per il risultato — il che significava che il progetto copriva i nostri costi di ricerca dandogli anche un pezzo fresco e inaspettato di storytelling.