Insights do Projeto: Como a rendersnek Produziu um Anúncio Estilo Documentário com IA

Descobre como a rendersnek criou um conceito FOOH completo usando IA — desde ambientes e personagens até narração — e o que os estúdios podem aprender com isso.

Um artigo convidado da rendersnek

Todo estúdio de FOOH ou CGI já enfrentou esse problema pelo menos uma vez: um cliente chega com uma ideia tão grande, tão tecnicamente ambiciosa, que quase beira uma produção de Hollywood.

No ano passado, a Kockum Sonics — uma empresa suíça especializada em sistemas de alarme acústico — veio com uma ideia que, naquela época, parecia ambiciosa demais para uma produção clássica.

Este ano, a situação tinha mudado. Com uma onda de novas ferramentas de IA agora no mercado, planos que antes pareciam “impossíveis” de repente se tornaram realizáveis com uma fração do orçamento. Então revisitamos o conceito — não apenas para cumprir o briefing, mas para usá-lo como um teste para o pipeline de IA mais avançado de hoje.

Transformamos a visão deles num experimento completo: poderíamos construir um mini-documentário inteiro com IA, desde ambientes e personagens até narração e cenas de desastres? E no final, surpreendemos o cliente com o resultado.

Sabíamos desde o início que esta não era uma tarefa para uma produção FOOH clássica, para a qual normalmente somos contratados. Mesmo assim, ainda queríamos aceitar o desafio. Então tornou-se um experimento aberto: poderia um conceito visual inteiro ser produzido exclusivamente com IA?

O que começou como um ponto de interrogação tornou-se numa realização completa de 30 segundos com IA — completa com ambientes, personagens, cenas de desastres e um narrador autêntico conduzindo a história. E foi assim que fizemos acontecer.

Fase 1: Pesquisa & Procura de Referências (Fundações para Criação de Imagens)

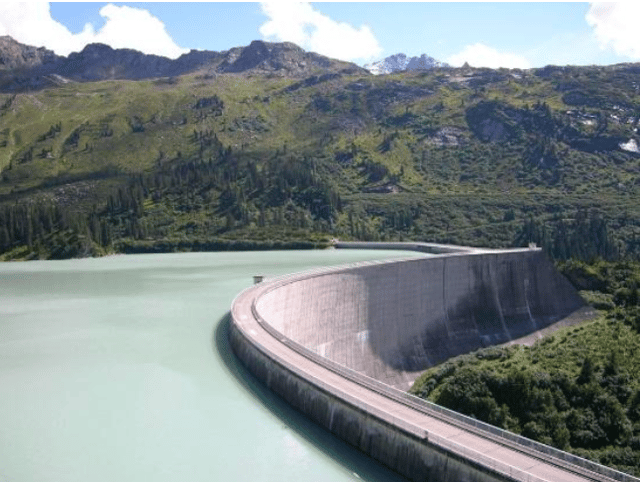

Primeiro, começamos com a caça de referências: reservatórios, arquitetura de barragens, vales alpinos. A barragem de Kaprun na Áustria serviu como uma âncora particularmente forte para escala e estrutura. A partir daí, o ChatGPT atuou como nosso co-diretor de imagem. Primeiro, começamos com a caça de referências: reservatórios, arquitetura de barragens, vales alpinos. A barragem de Kaprun na Áustria serviu como uma âncora particularmente forte para escala e estrutura.

A partir daí, o ChatGPT entrou como nosso co-diretor de imagem. Não jogamos descrições de cenas completas nele logo de cara. Em vez disso, trabalhamos em iterações apertadas: uma pista visual de cada vez, frequentemente pausando para refinar antes de adicionar o próximo detalhe — seja óptica, localização ou atmosfera.

Em vez de roteirizar tudo quadro por quadro, o ChatGPT ajudou-nos a traduzir essas referências diretamente em prompts de imagem. Esse processo tornou-se o motor para gerar as primeiras imagens base utilizáveis.

Fase 2: Criação de Imagens Base — Personagens e Ambientes

Dois pilares conduziram esta fase:

um narrador estilo documentário (calmo, inteligente, ao ar livre) e

as imagens base ambientais (parede da barragem, reservatório, vale, linhas florestais, perspetivas abaixo da barragem).

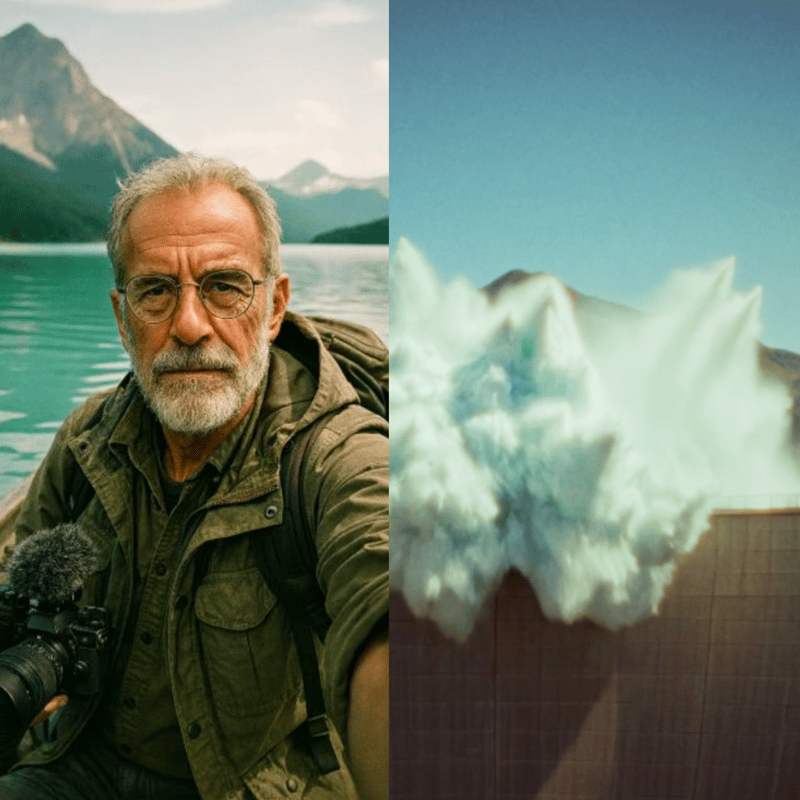

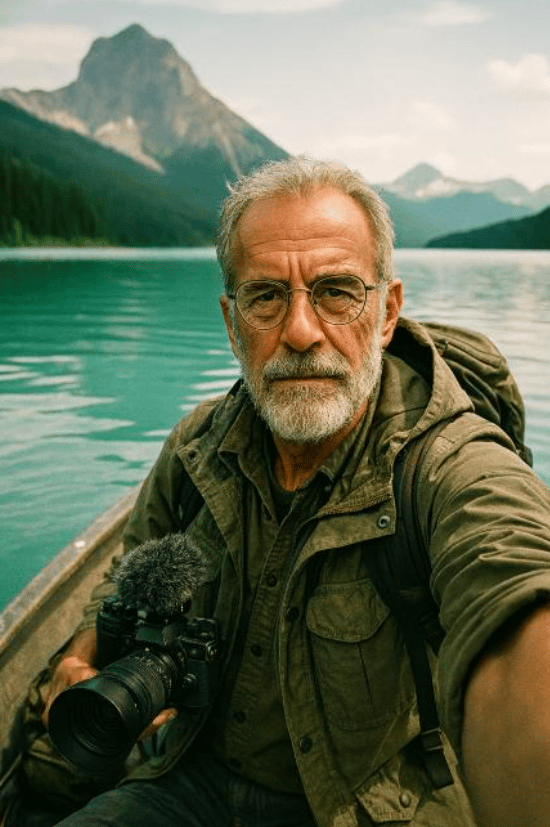

Para o personagem, o desafio era desenhar alguém que parecesse autêntico, uma figura que pudesse convincentemente carregar uma voz de documentário através de múltiplas cenas, mantendo-se visualmente consistente. Começamos com referências do mundo real: homens mais velhos com óculos, barbas claras e roupas de exterior.

A partir daí, construímos a persona através de um diálogo iterativo de prompts com o ChatGPT. Movendo-nos em pequenos passos — pausando para “aguardar mais instruções”, depois camadas de novas pistas como localização ou óptica de câmara — moldamos um narrador foto-realista que nunca existiu realmente, mas que instantaneamente projetava credibilidade e familiaridade.

Fragmentos de prompt usados ao longo do caminho (exemplos):

“Orador clássico de documentário, homem mais velho 60—70, óculos de armação fina, barba clara, roupa de explorador.”

“Hiper-foto-realista, look de filme analógico — Kodak Portra 400, Zeiss 50 mm, Minolta XD1, ligeiro grão, retrato 3:4.”

“Ele está a filmar-se numa perspetiva selfie num barco a remo no reservatório, olhando para a câmara; coloca algum equipamento de exterior/câmara no barco.”

Os ambientes requeriam um tipo diferente de disciplina: tinham de permanecer geograficamente estáveis para que as sequências de vídeo posteriores parecessem coerentes. A barragem de Kaprun na Áustria tornou-se uma âncora chave para escala e estrutura. Usando esta e outras referências, o ChatGPT gerou uma primeira biblioteca de imagens base — desde a parede da barragem e o reservatório até perspetivas de vale abaixo. A IA Generativa do Photoshop então refinou e estendeu estas saídas: corrigindo falhas, expandindo quadros para formatos cinemáticos, e inserindo pequenos detalhes definidores de identidade como cabanas ou linhas de árvores para garantir que cada cenário parecesse autêntico e conectado.

Fase 3: Consistência com o Modelo de Contexto Flux

Para ampliar e estabilizar o visual do narrador através de cenários, usamos o modelo de contexto Flux para gerar stills adicionais estilo vlog ancorados ao retrato base. Quando as saídas desviavam (características, roupa, micro-estilo), corrigimos-las no Photoshop ou re-executando passes Flux selecionados até o kit de personagem sentir-se solidamente travado.

Fase 4: Vlogs Falantes com Higgsfield (Google Veo 3, “Speak”)

Com os stills de personagem prontos, mudamos para Higgsfield, que aproveita o Google Veo 3 e uma ferramenta “Speak” incorporada para personagens falantes (sincronização labial, micro-movimento facial e áudio).

O que funcionou bem no Higgsfield na prática:

- Consistência da identidade vocal mesmo através de diferentes imagens base do mesmo personagem.

- Acoplamento apertado de áudio e movimento gerado dentro de um fluxo de trabalho (menos transferências).

- Iteração rápida para conteúdo talking-head — ideal para os segmentos de vlog que “seguram a mão do espetador” através da história.

Exemplo de prompt usado: “Este vlogger de documentário está em frente a uma parede de barragem no meio da natureza serena e fala aos seus espetadores com uma voz calma e curiosa. Ele soa como um orador de documentário antigo.”

Através de tomadas e cenários, o personagem manteve a mesma personalidade vocal e coerência visual.

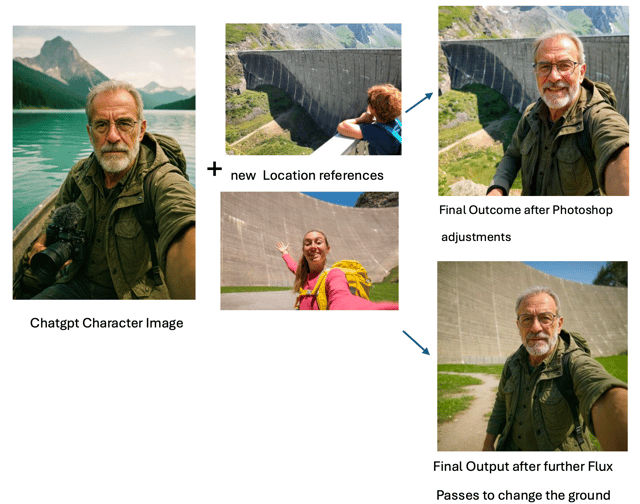

Fase 5: Cinematografia de Desastres com Kling 2.1 Master

Para ação cinemática e natureza, testamos Veo 2, Veo 3 e outros. Dentro da suíte de IA da Freepik, o claro vencedor para as sequências complexas de desastres foi o Kling 2.1 Master. Foi o único modelo que, com iteração suficiente, conseguiu render credível:

- um deslizamento de terra caindo num lago de montanha (0:16),

- a onda de enchente resultante ameaçando o vale (0:23), e

- A sirene emitindo pulsos tipo onda de choque que encontram e “neutralizam” a onda (a resolução literal do filme) (0:30).

Estes prompts eram altamente específicos e não-genéricos; a maioria dos modelos lutou para analisá-los.

O Kling não era mágico fora da caixa, mas deu-nos blocos de construção utilizáveis após experimentação persistente.

Para apoiar o processo de prompting, usamos o Freepik Prompt Enhancer, que ajudou a articular instruções visuais mais precisamente — especialmente quando a linguagem certa para um efeito específico era difícil de definir.

Para sequências mais simples, o Kling funcionou perfeitamente com esforço mínimo — que é de onde vieram observações como “movimento realista, transições de câmara suaves, alta aderência a prompt, custo-efetivo” em primeiro lugar:

- planos de estabelecimento da barragem,

- perspetivas aéreas amplas,

- panorâmicas suaves e comportamento de câmara,

- iluminação natural convincente.

Esses foram os lugares onde simplesmente funcionou — rápida e limpamente.

Prompt para produzir o plano aéreo:

“A câmara ascende lentamente, inclinando-se para baixo conforme a vista transita para uma perspetiva de olho de pássaro sobre o lago sereno. A cena mostra a barragem e montanhas circundantes em detalhe vibrante, destacando a beleza natural da paisagem.”

Fase 6: Clonagem de Voz com ElevenLabs

Queríamos a mesma voz dos vlogs Higgsfield para uma narração mais longa, abrangendo cenas. Começamos a treinar um clone de voz no Elevenlabs usando os poucos clips Higgsfield disponíveis (não ideal de forma alguma). Idealmente, treinarias através da gama completa de uma voz — diferentes emoções, ritmo, intensidade, ambientes e assim por diante.

Mesmo assim, o clone era surpreendentemente bom dados os dados limitados de treino: timbre bastante consistente, na maior parte do tempo reconhecivelmente o mesmo narrador, e bom o suficiente para carregar a narração do filme com alguns ajustes manuais menores aqui e ali. Com um conjunto de dados mais amplo, esperaríamos muito maior nuance, gama dinâmica e realismo.

Fase 7: Colocando o clone a trabalhar e descobrindo emoção narrativa

Era agora altura de produzir realmente a narração para o filme usando o clone de voz recém-criado. O ChatGPT rapidamente criou um texto para o orador, que após alguns ajustes humanos da nossa equipa criativa estava bom para a narração.

Como as primeiras gerações pareciam bastante neutras, mergulhamos nas opções do ElevenLabs e táticas de script, pesquisando o que podia ser feito. O ElevenLabs recomenda oficialmente colocar algum tipo de direção narrativa após a linha falada no script:

e.g., “Sirenes estacionárias,” ele disse lentamente e seriamente.

Através de testes, contudo, descobrimos que o oposto funcionava melhor: colocar a pista emocional antes da linha falada. Por exemplo:

Lentamente e com gravidade, ele explica: “Sirenes estacionárias.”

Este método garantia que quando a linha era falada, a voz IA já estava “no personagem”. A desvantagem geral das pistas narrativas: estas pistas iniciais têm de ser cortadas manualmente depois. A vantagem: a entrega é muito muito mais convincente.

Outras técnicas chave incluíam:

- Usar marcadores <break time=“1.0s” /> para pausas precisas em vez de confiar na pontuação.

- Ajustar a configuração de Estabilidade para equilibrar entre variação expressiva e tom consistente

A combinação destas abordagens transformou a narração de robótica para narrativamente envolvente.

Fase 8: Montagem Final & Som

A passagem final juntou:

- Clips de vlog (Higgsfield / Veo 3 Speak),

- Sequências de desastres e paisagens (Freepik Kling 2.1 Master),

- Imagens base & visuais ambientais gerados principalmente com ChatGPT (depois refinados via IA Generativa do Photoshop e, para continuidade, o modelo de contexto Flux)

- Narração (clone ElevenLabs com narração roteirizada),

- Design sonoro, edição e timing (polimento manual com Davinci Resolve, também inclui uma ferramenta de legendagem automática, que usamos como linha base para timing).

A peça finalizada é um curto coeso, totalmente gerado por IA — dirigido por humanos. Executado por máquina e cortado e finalizado manualmente.

Reflexões & Aprendizagens

Olhando para trás, este projeto mostrou-nos tanto as forças como os limites do pipeline de IA de hoje. Vale a pena notar que conduzimos a experiência em julho de 2025 — e no pouco tempo desde então, várias das ferramentas que usamos já avançaram significativamente.

No lado técnico, as nossas principais aprendizagens são:

- Prompts complexos e não-genéricos ainda são difíceis

- Cenários simples e genéricos podem ser gerados convincentemente, com visuais deslumbrantes e forte aderência a prompt.

- ChatGPT é verdadeiro cavalo de trabalho para criação de imagens, traduzindo referências em imagens base utilizáveis e guiando um fluxo de trabalho iterativo.

- A IA Generativa do Photoshop é a cola, corrigindo, estendendo e alinhando planos em algo coerente.

- Higgsfield (Veo 3 com sua funcionalidade “Speak”) era surpreendentemente confiável para personagens falantes, mantendo voz e identidade consistentes.

- Clonagem de voz provou-se viável mesmo com dados mínimos, embora mais material claramente desbloquearia muito maior nuance.

- Narração com som natural era possível com a mistura certa de pistas emocionais, ajustes de timing e edição manual.

- Acima de tudo, nenhum modelo único cobria tudo — o sucesso veio do empilhamento de ferramentas e forte direção orientada por referência.

Mas a percepção maior foi mais criativa que técnica. A IA nunca foi o diretor criativo — era o assistente. Os visuais só funcionaram porque foram orientados por pesquisa, preparação e uma visão criativa clara. Cada quadro ainda requeria planeamento, experimentação e tomada de decisões.

Então sim, a IA pode acelerar a produção e fazer conceitos grandes, de “escala de Hollywood” de repente parecerem possíveis. Mas também te tenta para um buraco de perfeccionismo — perseguindo infinitamente o plano perfeito que pode nunca vir. A disciplina reside em saber quando deixar ir.

O valor real da IA, percebemos, reside em como amplifica a direção humana. Torna possíveis coisas que antes exigiam planeamento enorme no lado da produção e vastos recursos na pós-produção. Alguns planos não teriam sido viáveis de todo dentro da maioria dos orçamentos.

Nesse sentido, a IA funciona como um atalho — removendo camadas de logística e permitindo cenários que parecem verdadeiramente únicos. Mas o trade-off é que requer uma visão cristalina: como o resultado deveria parecer, como deveria sentir-se, e como deveria atrair as pessoas emocionalmente.

E embora a IA possa poupar tempo, essas produções estão longe de serem maravilhas de um clique. Cada sequência ainda leva incontáveis iterações, cortes e arranjo cuidadoso antes de se tornar convincente. As ferramentas aceleram o trabalho, mas o ofício permanece em como guias, refinas e montas.

Foi isso que também tornou partilhar o resultado com o cliente tão gratificante. Depois de todas as experiências, testes e re-cortes, ficamos curiosos sobre como eles iriam responder.

E o que disseram?

Ficaram genuinamente satisfeitos porque revisitamos a ideia deles e empurramos para tornar a sua visão real de uma nova forma. No final, não apenas abraçaram o resultado mas também pagaram pelo resultado — o que significou que o projeto cobriu os nossos custos de pesquisa ao mesmo tempo que lhes deu uma peça fresca e inesperada de storytelling.